WEKA 推出 NeuralMesh Axon:革新人工智能部署的突破性架构

WEKA's NeuralMesh Axon delivers an innovative fusion architecture designed to address the fundamental challenges of running exascale AI applications and workloads.

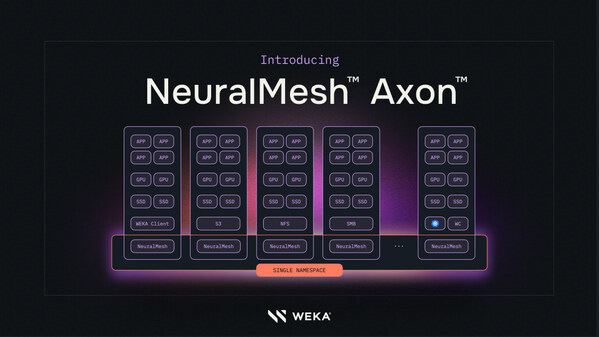

巴黎和加州坎貝爾——在 2025 年 7 月 9 日的 RAISE SUMMIT 2025 上,WEKA 宣布推出其最新的突破性存储系统 NeuralMesh Axon。此系统通过创新的融合架构,旨在解决百亿亿次人工智能应用程序和工作负载的基本挑战。NeuralMesh Axon 的推出标志着人工智能基础设施的重大进步,尤其是在大规模人工智能训练和推理工作负载的基础设施要求上实现了显著降低。

NeuralMesh Axon 的独特之处在于其能够无缝融合 GPU 服务器和人工智能工厂,从而简化部署、降低成本,并显著增强人工智能工作负载的响应能力和效能。这一系统不仅转变了未充分利用的 GPU 资源,还为用户提供了一个统一且高效的基础设施层。

突破性架构的背景与优势

NeuralMesh Axon 基于 WEKA 最近发布的 NeuralMesh 存储系统,后者通过强大的嵌入式功能增强了容器化微服务架构,帮助人工智能先驱、人工智能云端和云端新秀服务供应商加速大规模人工智能模型的发展。特别是在结合 NVIDIA AI Enterprise 软件堆栈时,NeuralMesh Axon 实现了高级模型训练和推理的优化。

在每秒百亿亿次运算下,人工智能基础设施障碍的复合性能是大型语言模型(LLM)训练和推理工作负载的成败关键。传统存储架构设计并非为即时处理和存储大量数据而设,导致数据工作流和人工智能工作流程中出现延迟和瓶颈。

行业领导者的观点与应用

早期采用者如 Cohere 等业界领先的企业已经看到了显著的转型成果。Cohere 是 WEKA 首批部署 NeuralMesh Axon 的客户之一,支持客户的人工智能模型训练和推理工作负载。Cohere 工程副总裁 Autumn Moulder 表示:

「对于人工智能模型构建者来说,速度、GPU 优化和成本效益是任务关键。这意味着更少硬件,生成更多权杖,并运行更多模型——而无需等待容量或迁移数据。」

此外,NeuralMesh Axon 在 CoreWeave Cloud 上的部署也为 Cohere 的安全人工智能代理平台 North 提供了坚实基础。CoreWeave 技术总监兼共同创办人 Peter Salanki 强调:

「我们正在进入人工智能进步超越原始运算的时代——它是由智能基础设施设计爆发的。」

未来展望与市场影响

NeuralMesh Axon 的推出为百亿亿次级人工智能构建者和云端服务供应商带来了即时且可量度的改进,包括扩展记忆体配加速权杖流通量、巨大 GPU 加速和效率提升,以及立即扩充大规模人工智能工作流程的能力。

WEKA 产品总监 Ajay Singh 表示:

「百亿亿次人工智能面临的基础设施的挑战,有别于业界过去面对的任何挑战。我们设计 NeuralMesh Axon 的原因,源于我们深度关注从 GPU 开始的每层人工智能基础设施优化。」

NeuralMesh Axon 目前仅向大型企业人工智能和云端新秀客户限量提供,预计将于 2025 年秋季全面上市。有关更多信息,请访问 WEKA 的官方网站。