苹果新研究揭示AI可通过文本描述识别用户活动

IT之家11月22日消息,科技媒体9to5Mac昨日(11月21日)发布博文,报道称在最新公布的研究报告中,苹果指出大语言模型(LLM)可通过分析音频和运动数据的文本描述,精准识别用户活动,未来可能会应用于Apple Watch上。

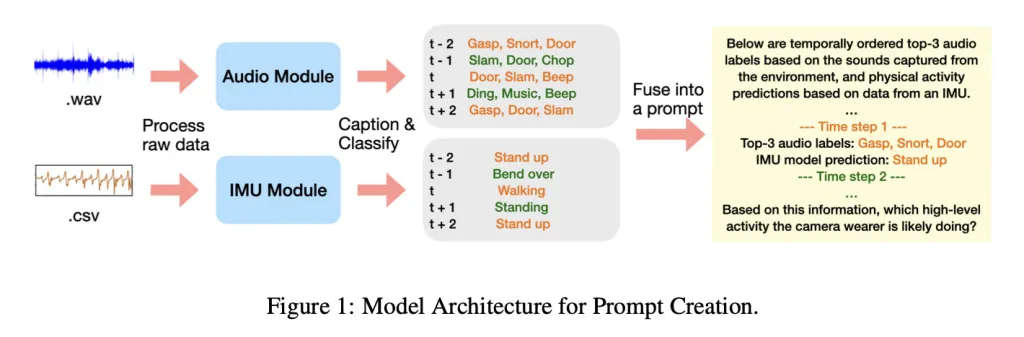

这项名为“后期多模态传感器融合”(Late Multimodal Sensor Fusion)的技术,主要结合LLM的推理能力与传统传感器数据,即使在传感器信息不足的情况下,也能精确判断用户正在进行的具体活动。

技术创新与隐私保护

研究的核心方法颇具新意。大语言模型并未直接处理用户的原始音频录音或运动数据,而是分析由专门的小型模型生成的文本描述。具体来说,音频模型会生成描述声音环境的文字(如“水流声”),而基于惯性测量单元(IMU)的运动模型则会输出动作类型的预测文本。这种方式不仅保护了用户隐私,还验证了LLM在理解和融合多源文本信息以进行复杂推理方面的强大能力。

实验验证与结果

为验证该方法,研究团队使用了包含数千小时第一人称视角视频的Ego4D数据集。他们从中筛选出12种日常活动,包括吸尘、烹饪、洗碗、打篮球、举重等,每段样本时长20秒。

随后,研究人员将小模型生成的文本描述输入给谷歌的Gemini-2.5-pro和阿里的Qwen-32B等多个大语言模型,并测试其在“零样本”(无任何示例)和“单样本”(提供一个示例)两种情况下的识别准确率。

测试结果显示,即使没有任何针对性地训练,大语言模型在活动识别任务中的表现也远超随机猜测的水平,其F1分数(衡量精确率和召回率的指标)表现优异。当获得一个参考示例后,模型的准确度还会进一步提升。

未来应用与行业影响

这项研究表明,利用LLM进行后期融合,可以有效开发出强大的多模态应用,而无需为特定场景开发专门模型,从而节省了额外的内存和计算资源。苹果公司还公开了实验数据和代码,以供其他研究者复现和验证。

此项技术的潜在应用范围广泛,尤其是在可穿戴设备领域,如Apple Watch,能够通过更智能的方式监测和分析用户的日常活动。这不仅提升了设备的功能性,也为用户提供了更个性化和隐私保护的体验。

随着科技的不断进步,如何在保障用户隐私的同时提升智能设备的功能性成为各大科技公司关注的重点。苹果此次的研究无疑为行业提供了新的思路和方向。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。